Había una vez un tipito que se llamaba Sam Altman que, tras idas y vueltas, quedó como responsable de una empresita llamada OpenAI. Un tipo que con algo de riesgo, dinero y contactos, puso un producto en manos y voz de la gente, un generador de texto contextual multilenguaje y multimodal, llamado ChatGPT.

El producto funciona bastante bien: el texto que genera puede ser utilizado de manera práctica: incluso, hay personas que lo usan como ayuda psicológica. Y a los que somos programadores, nos ahorra horas en buscar información en foros y entre pares.

ChatGPT, para quien no está muy entendido, se basa en modelos de lenguaje creados y mantenidos por OpenAI. Modelos que se alimentan de internet y de diversa documentación (y mayoritariamente con derechos de autor). Claro, OpenAI no es la única en crear estos modelos.

Actualmente existe una carrera voraz entre empresas multimillonarias por saber quién tiene el modelo más grande y fuerte. Google tiene a Gemini, X a Grok, y otras empresas se crearon y se subieron al ring, como Anthropic y su preciso Claude.

Sam, como portavoz y cara de esta época, tiene cosas un tanto interesantes para decir sobre cómo la IA puede “acabar con la humanidad”. Sin ir más lejos, les dejo cinco citas de nuestro querido hombre alterno (Alt – man… me voy solo):

1. Mayo 2023 — “Superhuman machine intelligence is probably the greatest threat to the continued existence of humanity.”

Altman afirmó que una inteligencia artificial superhumana constituye probablemente la mayor amenaza para la continuidad de la humanidad. New York Magazine

2. Diciembre 2023 — “I’m a little bit scared” de la IA y temores sobre regímenes autoritarios

En una entrevista con ABC News, admitió sentir “un poco de miedo” sobre el impacto de la IA en el trabajo, elecciones y desinformación, y expresó preocupaciones sobre regímenes autoritarios desarrollando IA competitiva. CNBC

3. Mayo 2024 — “Capable of causing significant global harm”: regulación global urgente

En el podcast All-In, Altman declaró:

“I think there will come a time… frontier AI systems are capable of causing significant global harm”

y abogó por una agencia internacional que regule los sistemas más poderosos. Reddit

4. Diciembre 2024 — “Hope someone figures out how not to destroy humanity”

Durante el evento Dealbook del NY Times, expresó:

“I have faith that researchers will figure out… maybe the AI itself will be so smart that it will just figure out how to rein itself in.”

Reflexionó sobre la necesidad de coordinación global para evitar que la IA destruya a la humanidad. CNN

5. Agosto 2025 — “GPT-5 scares me… the Manhattan Project feels very fast…”

En el podcast This Past Weekend, comparó el desarrollo de GPT-5 con el Proyecto Manhattan, dijo sentirse asustado y que la velocidad del avance IA sugiere que “no hay adultos en la sala”. Tom’s GuideWindows Central

No dudo, en absoluto, que la generación de texto es una herramienta excesivamente útil para nuestro trabajo. Vino para quedarse, como el Covid y Sydney Sweeney. ¿Pero es para tanto?

Grandes posibilitadores, flojos consejeros

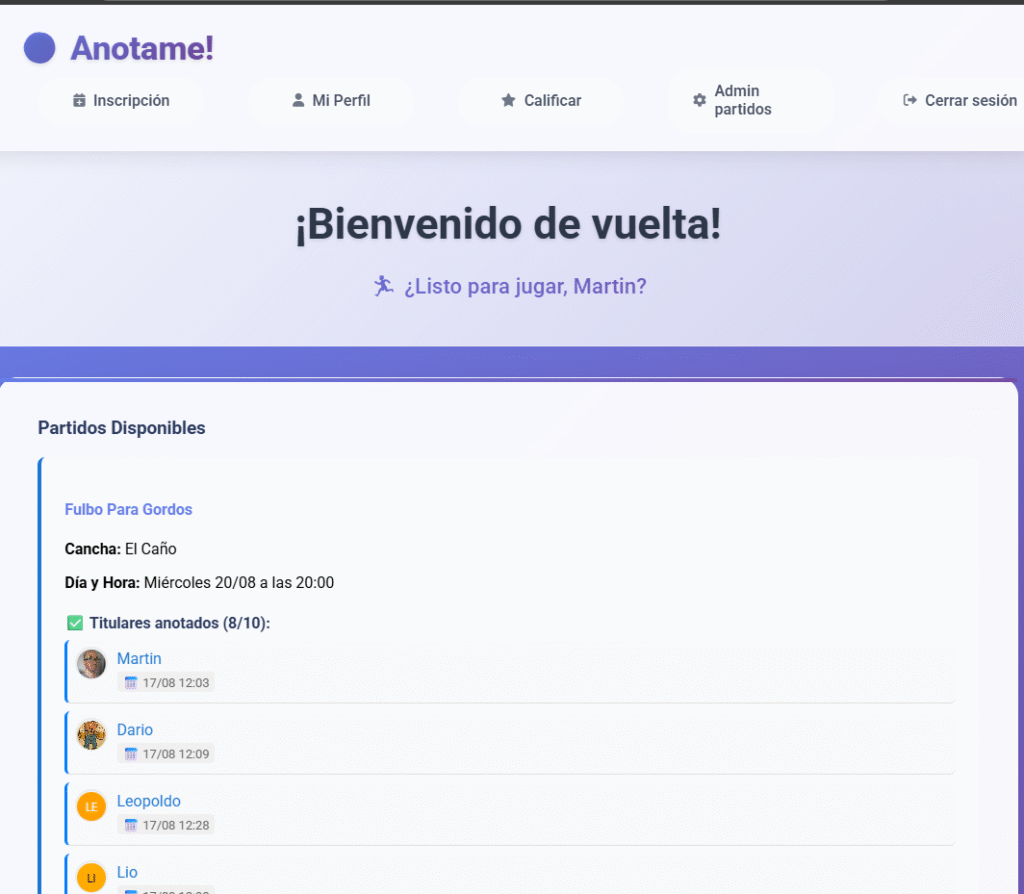

En este mes, puse a prueba las capacidades de algunos modelos de generación de texto con Cursor, Claude y el recién salido GPT-5. Hice puntualmente 2 cosas de manera intensiva, el revamping de Ánima Inteligencia y un prototipo que ya se está usando.

El rearmado del sitio quedó muy bien. No valía la pena tener un WordPress con un template levantado comiendo base de datos ni nada adicional, así que lo que quedó actualmente me deja conforme.

Sin embargo, es cierto que con algunos bloques animados y con algunas cuestiones de estilo tuvo problemas que hubo que corregir. No hizo un trabajo espectacular, pero lo hizo bastante bien. Demasiado para una tarde. Sí tuve que pelear mucho con el logo: ni ChatGPT ni Claude fueron capaces de generar un logo funcional con una simple instrucción, así que me quedé con una linda fuente de Google que remarca que los primeros en ser “AI”, fuimos nosotros 😉.

“Pero seguro no te gustó el logo y es una cuestión de gustos!”. No:

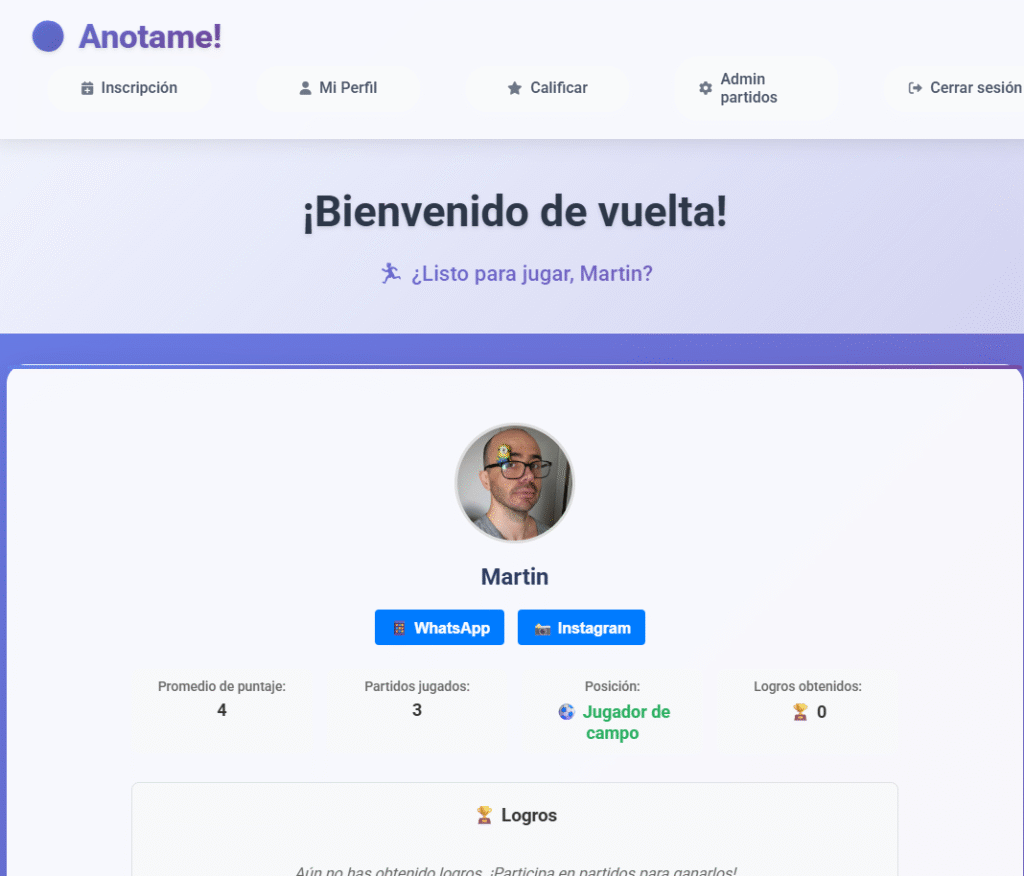

Sobre la app para fútbol, que está en beta para familia y amigos, la IA hizo un “buen” trabajo. Sin embargo, noté que en la composición de la solución se fue quedando. No pudo respetar una estructura lógica, y también es cierto que le costó la generación de consultas en SQL, generando tablas con nombres en mayúsculas, minúsculas, espaciados, entre otros; sin ningún criterio en específico.

Además, sucede que en ocasiones, al arreglar una cosa, la IA rompe muchas otras, relativas a las reglas de negocio, sesión activa, etc.. Hay que revisar muy bien lo que la IA cambia antes de aceptar el cambio, o se corre el riesgo de romper todo lo que funciona.

El elefante en la habitación

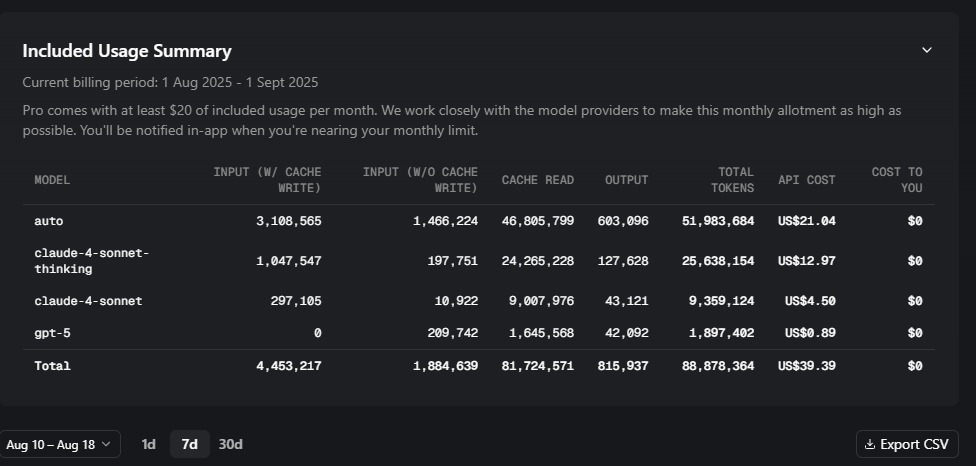

Lo que ves arriba es el uso que le di a Cursor en este mes. Pagué 15 dólares (20 que cuesta originalmente menos 5 por una promo bancaria) y tuve, al momento de escribir esta nota, el uso de 39.39 dólares en tokens de los modelos señalados arriba. El único uso que le di a la app es el que comenté. Es decir, si bien no es especialmente caro, tampoco es un gasto que pueda ser ignorado.

Ahora, todos los que usamos IA sabemos que estamos “comiendo dinero” de los fondos de riesgo, que invierten dinero con tal de quedarse con una porción cada vez más grande de la compañía donde invierten, sin saber si finalmente será rentable.

Si pagué 15, y el costo para la empresa fue de 2,5 veces lo que pagué, algo no cierra. Sé que tarde o temprano esto se acaba, y es un brillante momento para hacer algo apalancados (indirectamente) por estos fondos.

Sam intenta, constantemente, vender que los modelos de OpenAI son cada vez mejores, aunque se ve que ya estamos llegando a la meseta de la tecnología. De ahora en adelante, veremos optimizaciones en costos, para que las empresas puedan ofrecer sus servicios con un mejor margen de ganancias. No me caben dudas que GPT-5 fue un intento de optimización que salió bastante mal, pero que es un paso en esa dirección.

Esto recién empieza.